Вы собираетесь узнать стратегию в одной из самых сложных SEO кампаний, которые когда-либо мы делали.

Почему это было так сложно? 3 причины:

- Во-первых, в этой нише очень высокая конкуренция: инфопродукт, позволяющий зарабатывать деньги в Интернете, в финансовой нише

- Во-вторых, у нас было всего 5 месяцев, чтобы осуществить это.

- В-третьих, как и все клиенты, они крайне жаждали результата и требовали качественной работы.

В приведенном ниже кейсе вы изучите схему, стратегию продвижения и методы построения ссылок, которые мы использовали, чтобы добиться роста доходов на 45,99% для этого бизнеса по созданию информационных продуктов.

Методы SEO продвижения: Практический кейс

Ниши нашего клиента достаточно обширна, ведь его продукт может быть интересен среди стремящихся найти дополнительный заработок, торгуя в Интернете. Мы говорим об инвестициях в валюту, фондовый рынок, крипту и т. д.

Доход бизнеса генерируется исключительно за счет продажи цифровых продуктов – в данном случае гайдов в формате электронных книг и видеокурсов по торговле.

Когда владелец этого прибыльного бизнеса (который уже завоевал некоторый авторитет в своей нише) обратился к нам с просьбой помочь им увеличить органический охват и найти новых студентов, мы были рады принять вызов в одном из самых конкурентных ниш.

Но была и загвоздка: рекламная кампания планировалась всего на 5 месяцев, тайминг в данном случае был очень коротким.

Чтобы добиться этого, план игры заключался в том, чтобы сосредоточиться на стратегии быстрого продвижения и одновременно закладывать условия для долгосрочного результата.

Наши стратеги были уверены, что ценность, которую мы сможем обеспечить, окажет значительное влияние на прибыль его бизнеса.

Как? Потому что…

Сосредоточив наше внимание на увеличении органического трафика, мы могли бы увеличить продажи, одновременно позволяя клиенту сократить расходы на рекламу.

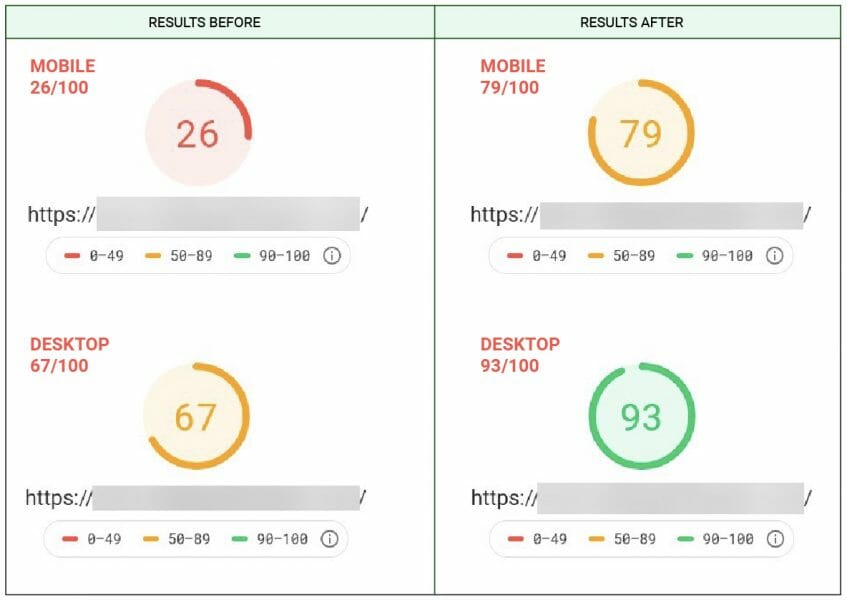

В ходе кампании наши технари в области SEO смогли увеличить органический трафик на 23,46%.

Но что больше всего помогло бизнесу клиента, так это увеличение количества конверсий на 45,99% по сравнению с прошлым месяцем. Продажи выросли с чуть более 2100 в месяц до 3095.

И мы сделали это вовремя.

Эти результаты были достигнуты всего за 5 месяцев после того, как клиент подписал с нами контракт и мы начали работать.

Вот как мы это сделали…

Руководство по SEO для веб-сайтов с информационными продуктами

Этап 1: Комплексный технический аудит

Я говорил об этом в каждом кейсе, которое мы публиковали до сих пор… и я просто не могу это не подчеркнуть:

Комплексный технический аудит — очень важная часть любой SEO кампании.

Поэтому прежде чем начинать любую кампанию, всегда начинайте с полного технического аудита .

Начиная с…

Скорость страницы

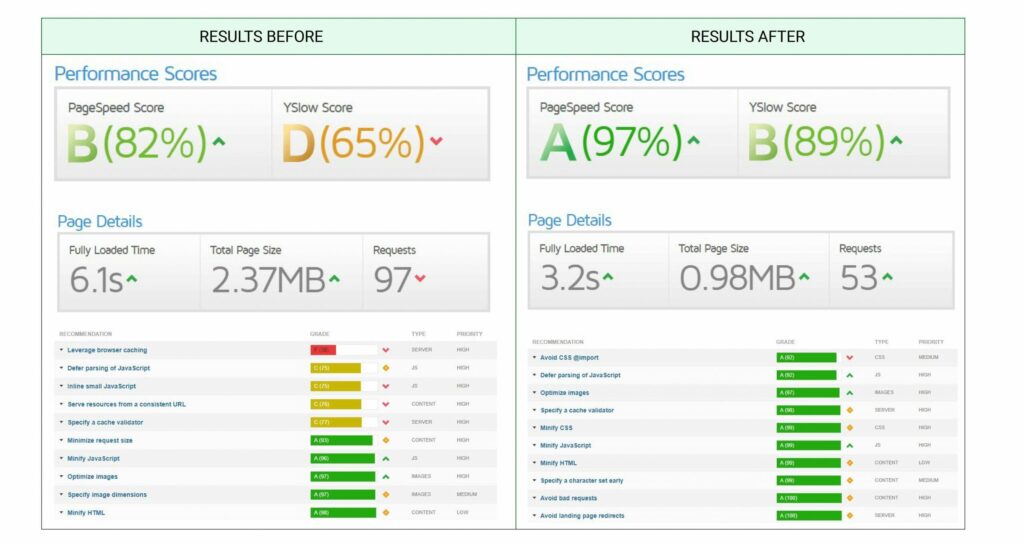

Во-первых, наши специалисты по технической SEO-стратегии начали с самых низов технологического стека клиента… и вам тоже следует это сделать.

Все начинается с изучения конфигурации веб-сервера и выполнения серии тестов для измерения скорости сайта.

Это позволяет вам гарантировать, что производительность самого веб-сервера не приводит к снижению производительности или ухудшению качества захода через ПК или мобильным устройствам.

Итак, какие тесты мы проводим?

- PageSpeed Insights (PSI) – это должно быть универсальный инструмент, который не требует объяснений.

- GTmetrix – полезно перепроверять результаты PSI, поэтому мы используем как минимум еще один инструмент. На самом деле мы используем GTmetrix вместе с Dareboost , Uptrends и Webpagetest.

- Тест HTTP/2 — этот тест становится стандартом, который может значительно улучшить скорость вашей страницы, поэтому на него определенно стоит обратить внимание. Если у вас не включен HTTP/2, возможно, вам стоит подумать о смене сервера или использовании CDN.

В идеале вы должны увидеть это:

Тест производительности . Я знаю, что это может показаться излишним, но мы включили его в наш набор тестов в этом году для сайтов, которые на которых может быть единовременный наплыв трафика. Мы даже не говорим о трафике уровня Amazon, но скажем, что если ваш сайт получит 1000 посещений за минуту. Что случится? Справится ли сервер с этим или не выдержит? Если этот тест покажет вам стабильное время отклика менее 80 мс — все в порядке. Но помните – чем ниже время отклика, тем лучше!

В случаях, когда время отклика является высокой мы советуем вам (и нашим клиентам) рассмотреть возможность перехода на более быстрые серверы, перехода на более качественный хостинг или, что еще лучше, перейти на CDN.

К счастью, в большинстве случаев вы можете добиться лучшей производительности за счет плагина WPRocket для WordPress, как сделали и мы.

Настройки в WPRocket

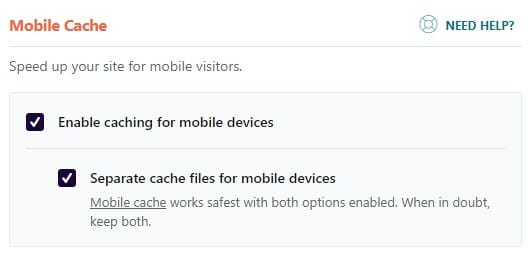

Кэш → Включить кеширование для мобильных устройств (Cache → Cache Lifespan)

Эта опция должна быть всегда включена. Это гарантирует, что для мобильных устройств будет всегда включено кэширование.

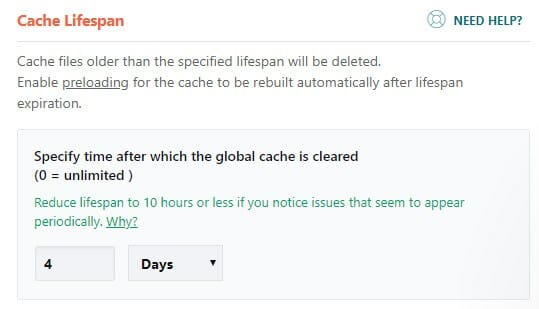

Кэш → Срок службы кэша (Cache → Cache Lifespan)

Установите это значение в зависимости от того, как часто вы обновляете свой сайт, но мы находим оптимальное значение в пределах 2–7 дней.

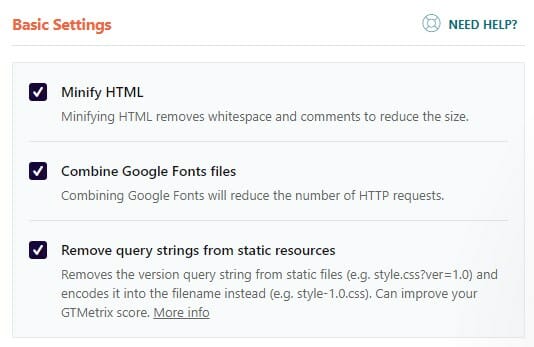

Оптимизация файлов → Основные настройки (File Optimization → Basic Settings)

Будьте осторожны с первым пунктом – он может сломать сайт!

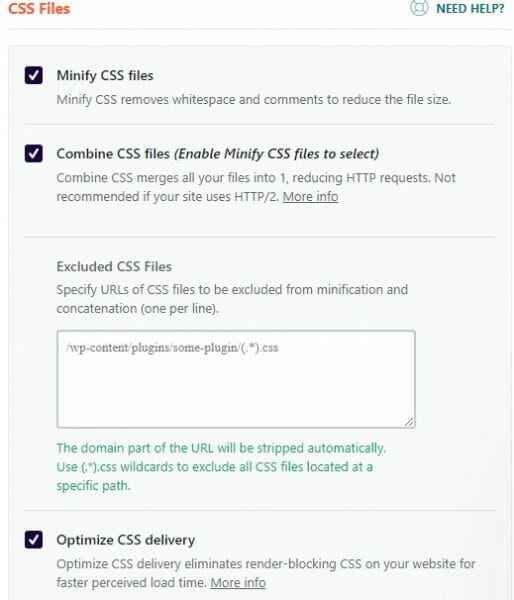

Оптимизация файлов → CSS-файлы (File Optimization → CSS Files)

Опять же настраивать этот раздел надо очень аккуратно, есть опасность и здесь что-то сломать. Я включаю указанные пункты по одному и смотрю, нормально ли работает сайт после включения каждой опции.

В разделе «Резервный критический CSS (Fallback critical CSS)» вам следует вставить свой CSS «Критический путь», который вы можете создать с помощью сайта CriticalCSS .

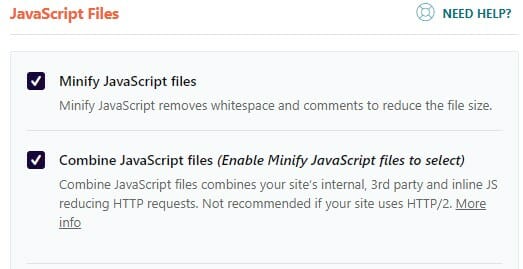

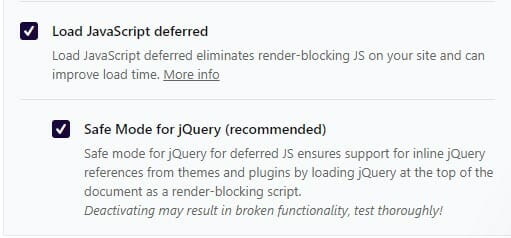

Оптимизация файлов → Javascript

В этом разделе чаще всего что-то ломается, поэтому будьте предельно осторожны, включая эти опции!

В зависимости от вашей темы вы можете отложить загрузку Javascript, выполнив следующие действия:

Обратите внимание, что нам пришлось использовать безопасный режим для jQuery, так как без этого наша тема переставала работать.

Поигравшись с опциями Javascript, обязательно тщательно протестируйте свой сайт, включая все контактные формы, ползунки, оформление заказа и пользовательские функции.

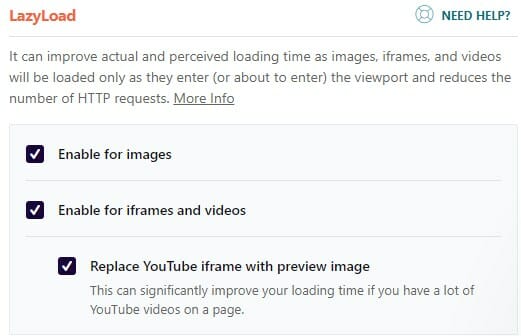

Медиа → LazyLoad (Media → LazyLoad)

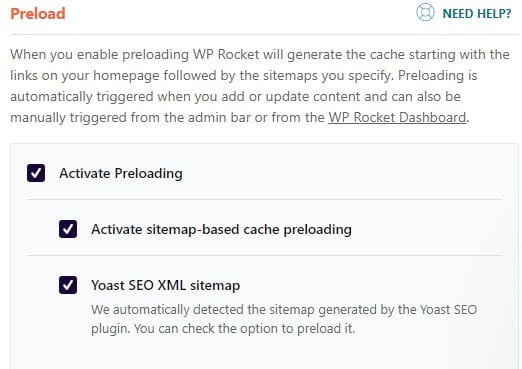

Предварительная загрузка → Предварительная загрузка (Preload → Preload)

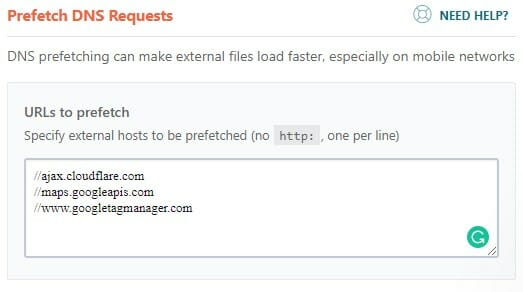

Предварительная загрузка → Предварительная выборка DNS-запросов (Preload → Prefetch DNS Requests)

URL-адреса — здесь во многом зависят от вашей темы. Здесь вам следует вставить домены внешних ресурсов, которые использует ваш сайт.

Кроме того, когда вы используете Cloudflare, обязательно включите надстройку Cloudflare в WPRocket.

Говоря о Cloudflare — это последний пункт к повышению производительности сайта, используя Cloudflare в качестве провайдера CDN — наш клиент продает цифровые товары по всему миру.

GTMetrix

Если вы не хотите использовать дополнительные плагины (которые я настоятельно рекомендую), ниже приведен код .htaccess. Он выполняет такие основные функции, как:

- GZip-сжатие

- Срок действия заголовков

- Контроль кэша

Таким образом, без каких-либо плагинов для оптимизации WordPress этот код, добавленный в начало вашего файла .htaccess, немного улучшит ваши результаты PageSpeed Insights:

<IfModule mod_deflate.c>

AddOutputFilterByType DEFLATE text/html text/plain text/xml application/xml application/xhtml+xml text/css text/javascript application/javascript application/x-javascript

</IfModule>

<IfModule mod_expires.c>

ExpiresActive on

ExpiresDefault "access plus 1 month"

# CSS

ExpiresByType text/css "access plus 1 year"

# Data interchange

ExpiresByType application/json "access plus 0 seconds"

ExpiresByType application/xml "access plus 0 seconds"

ExpiresByType text/xml "access plus 0 seconds"

# Favicon (cannot be renamed!) and cursor images

ExpiresByType image/x-icon "access plus 1 week"

# HTML components (HTCs)

ExpiresByType text/x-component "access plus 1 month"

# HTML

ExpiresByType text/html "access plus 0 seconds"

# JavaScript

ExpiresByType application/javascript "access plus 1 year"

# Manifest files

ExpiresByType application/x-web-app-manifest+json "access plus 0 seconds"

ExpiresByType text/cache-manifest "access plus 0 seconds"

# Media

ExpiresByType audio/ogg "access plus 1 month"

ExpiresByType image/gif "access plus 1 month"

ExpiresByType image/jpeg "access plus 1 month"

ExpiresByType image/png "access plus 1 month"

ExpiresByType video/mp4 "access plus 1 month"

ExpiresByType video/ogg "access plus 1 month"

ExpiresByType video/webm "access plus 1 month"

# Web feeds

ExpiresByType application/atom+xml "access plus 1 hour"

ExpiresByType application/rss+xml "access plus 1 hour"

# Web fonts

ExpiresByType application/font-woff "access plus 1 month"

ExpiresByType application/vnd.ms-fontobject "access plus 1 month"

ExpiresByType application/x-font-ttf "access plus 1 month"

ExpiresByType font/opentype "access plus 1 month"

ExpiresByType image/svg+xml "access plus 1 month"

</IfModule>

<IfModule mod_headers.c>

<FilesMatch ".(jpg|jpeg|png|gif|swf|JPG)$">

Header set Cache-Control "max-age=31536000, public"

</FilesMatch>

<FilesMatch ".(css|js)$">

Header set Cache-Control "max-age=31536000, private"

</FilesMatch>

</IfModule>Внутренние редиректы (Internal Redirects)

Вы знаете, как это бывает: Google утверждает, что редиректы не способствуют потери ссылочного веса, но формула и тесты PageRank показывают нечто иное (научный тест, проведенный на 41 миллионе веб-сайтов .it , показывает, что при передачи ссылочного веса с помощью редиректа, передаётся не весь ссылочный).

Что бы это ни было, давайте примем все необходимые меры предосторожности на тот случай, если мы будем использовать редиректы и не хотим потерять ссылочный вес.

Кроме того, отказ от использования внутренних редиректов — это весьма неплохая идея.

Исследуя конфигурацию сервера, мы обнаружили некоторые неправильно примененные внутренние редиректы, которые очень легко исправить, но они окажут значительное влияние на SEO – быстрый выигрыш.

Вы можете протестировать их с помощью простого инструмента httpstatus.io и увидеть результаты для отдельных URL-адресов:

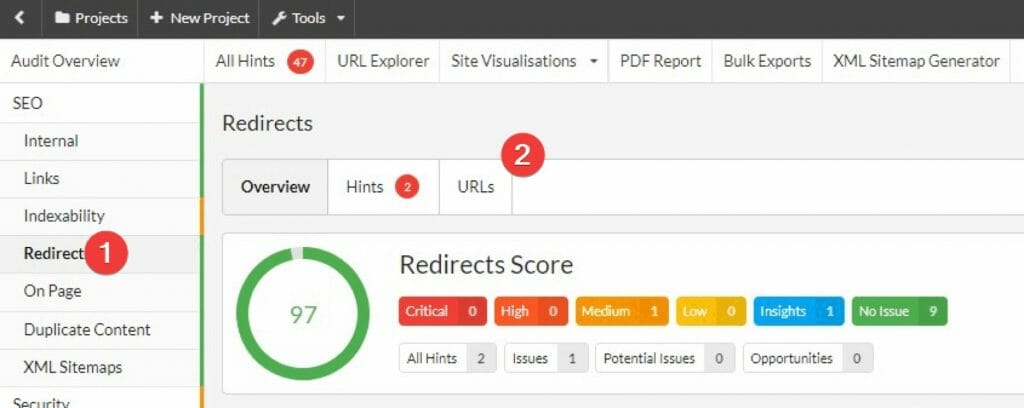

Но это будет долгий путь, верно? Поэтому лучше всего запустить сканирование Sitebulb, перейти в раздел сканирования «Редиректы» и просмотреть внутренние редиректы URL-адреса ( Internal Redirected URLs):

Там вы найдете список всех URL-адресов с внутренним редиректом, которые вам следует обновить и указать на последний адрес в цепочке редиректов.

Возможно, вам придется повторить сканирование несколько раз, чтобы найти их все. Будьте терпиливы!

Управление индексацией Яндекса и Google

Все знают, что Яндекс и Google сканируют и индексируют сайты. Это основа того, как работает поисковые системы.

Они посещает сайты, переползая от одной ссылки к другой. Делается ли это постоянно, чтобы поддерживать индекс в актуальном состоянии, а также постепенно, открывая новые сайты, контент и информацию.

Со временем, сканируя ваш сайт , Google видит его изменения, изучает структуру и проникает во все более глубокие его части.

Поисковик хранит в своем индексе все, что считает нужным сохранить; все, что считается достаточно полезным для пользователей и самого Google.

Однако иногда он попадает на страницы, индексации которых вы не хотите. Например, страницы, которые случайно создают проблемы, такие как дублирование или недостаточное содержание, материалы, хранящиеся только для авторизованных пользователей.

Поисковик делает все возможное, чтобы отличить то, что следует индексировать, а что нет, но иногда он может ошибаться.

Вот здесь-то и должны вступить в игру специалисты по поисковой оптимизации. Мы хотим подавать поисковику весь контент на серебряном блюдце, чтобы ему не приходилось алгоритмически решать, что индексировать.

Убираем то, что уже проиндексировано, но не должно было быть. Мы также предотвращаем индексацию страниц и следим за тем, чтобы важные страницы находились в пределах досягаемости сканеров.

Большинство сайтов этого не делают.

Почему?

Скорее всего, потому, что это постоянная работа, и владельцы сайтов и оптимизаторы просто забывают выполнять ее каждый месяц или около того.

С другой стороны, выявить раздувание индексации также не так-то просто.

В рамках этой кампании, чтобы гарантировать оптимальную индексацию сайта , мы рассмотрели следующее:

- Сайт: Поиск

- Консоль поиска Google

В нашем случае мы обнаружили 3 основные области, требующие внимания:

Индексация внутреннего поиска

Если ваш сайт установлен на движке WordPress – вам следует обратить внимание на текст ниже.

Большинство сайтов на WordPress имеют встроенную поисковую систему. И эта поисковая система обычно использует один и тот же шаблон: ?s={query}.

Имейте в виду, что ?s= является значением по умолчанию для WordPress, но если ваша тема позволяет вам настроить это самостоятельно, вместо параметра «s» у вас может оказаться что-то другое.

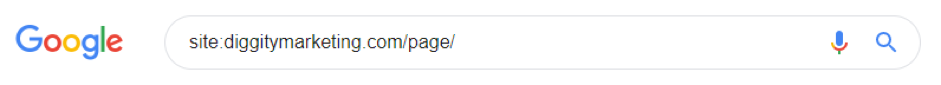

Чтобы проверить, является ли это и вашей проблемой, воспользуйтесь этим оператором в Google:

сайт:domain.com inurl:s=

Если в поиске появляются какие-либо результаты, это означает, что ваши внутренние поисковые страницы индексируются, что плохо для SEO продвижения

Для нашего клиента мы предложили реализовать теги noindex.

Если ваш SEO плагин не имеет возможности неиндексировать результаты поиска (я знаю, что Rankmath точно имеет такую возможность), то вы можете в качестве альтернативы добавить следующую строку в ваш robots.txt:

Disallow: *?s=*

Дублирующаяся домашняя страница

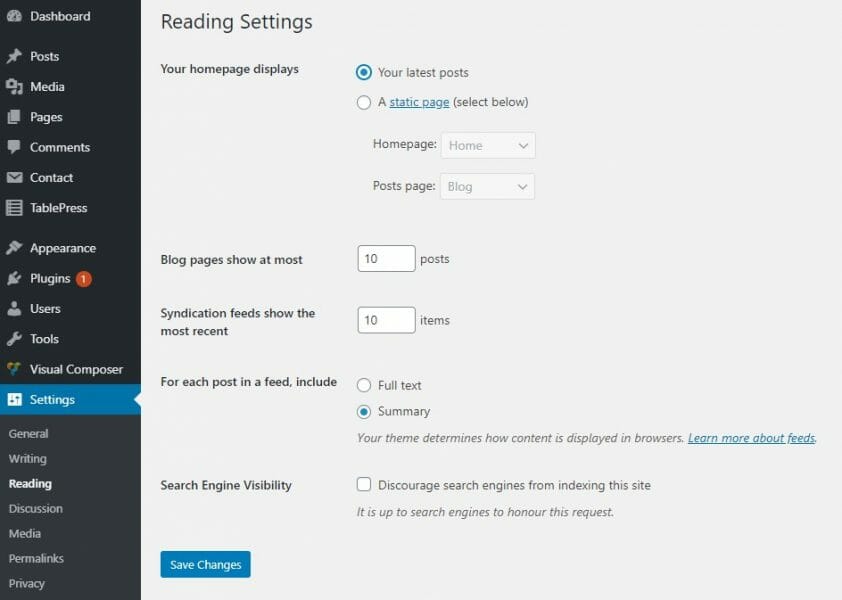

Это еще одна довольно распространенная проблема в WordPress, если вы используете статическую страницу в качестве домашней.

Видите ли, CMS может генерировать нумерацию страниц на вашей домашней странице, даже если у вас их на самом деле нет.

Почему это происходит? Ну, обычно, когда у вас есть раздел, в котором вы публикуете некоторые из своих последних постов. Или (спасибо WordPress!), когда ваша домашняя страница была настроена как «Последние публикации», и Google удаётся это индексировать.

При этом создаются такие URL — адреса:

domain.com/page/12/

domain.com/page/2/

domain.com/page/7/

domain.com/page/ { number }/

Проблема возникает из-за того, что Google видит одинаковый контент на этих страницах с разной нумерацией страниц — конечно, статьи на страницах 2, 3, x немного отличаются, поэтому список с нумерацией страниц меняется.

Стоит проверить, проиндексированы ли у вас похожие страницы – и вам обязательно стоит обратить внимание:

Чтобы найти их, запустите в Гугле другой оператор:

site:domain.com/page

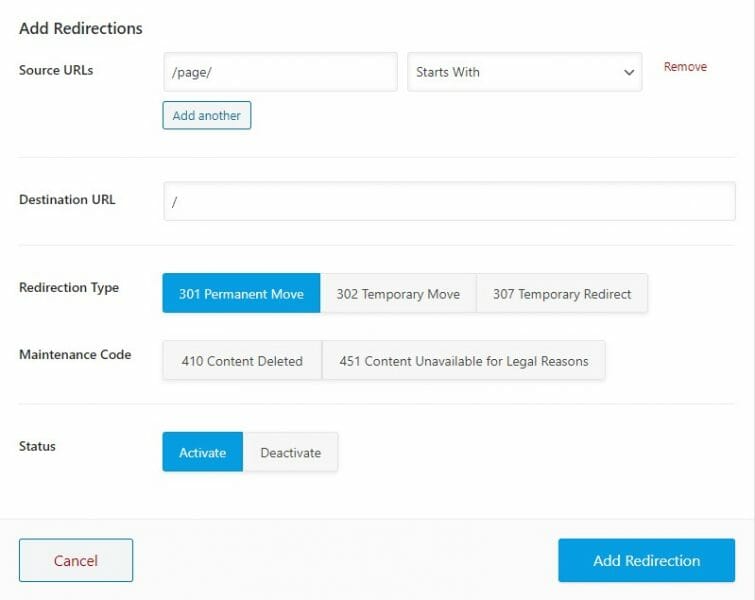

Чтобы решить эту проблему для нашего клиента, мы настроили 301 редирект, чтобы все эти страницы с нумерацией домашних страниц указывали обратно на главную страницу, а также удалили их из XML-карты сайта:

(Если вам интересно, этот скриншот взят из Rank Math , отличной бесплатной альтернативы Yoast, но вы также можете использовать любой плагин для редиректа на WordPress.)

Обратите внимание: если ваша домашняя страница настроена как страница блога (см. скриншот ниже), скорее всего это не будет являться проблемой.

Другие нежелательно проиндексированные страницы

В нашем случае мы также нашли другие страницы, которые были проиндексированы, но не должны быть в индексе:

- Старые страницы форума

- Старые страницы шаблонов

- Теги блога

- Страницы СМИ (еще раз спасибо, Yoast…)

В вашем случае эти страницы конечно же будут отличаться, поэтому вам следует проконсультироваться с агентством или профессиональным SEO-специалистом.

Для этого клиента мы удалили эти страницы и использовали HTTP-заголовок 410 Gone, чтобы быстрее удалить их из индекса.

Совет: Google операторы которые вы обязаны знать

site:domain.com

Это основные поисковые операторы, которые позволяют вам просмотреть все, что Google проиндексировал на вашем домене.

Мне нравится запускать такой поиск и включать просмотр сразу 100 результатов на страницу, добавляя параметр num=100 в Google:

https://www.google.com/search?q=site:domain.com&num=100

Затем я просто просматриваю результаты поиска и проверяю, что там.

Наиболее распространенными проблемами являются:

- Строки запроса

- Логин/Корзина/Оформить заказ

- Пагинация

- Теги

- ТЕщё разные сюрпризы 🙂

Обратите внимание, что это не работает для больших сайтов, поскольку Google покажет вам только небольшую часть URL-адресов.

site:domain.com/{folder}

Это всего лишь расширение стандартного сайта: позволяет найти все в папке.

Например, на сайте Shopify вы можете перечислить все страницы категорий, выполнив этот поиск:

сайт:domain.com/collections/

Двигаемся дальше…

site:domain.com inurl:{часть-URL}

Мне нравится этот оператор. Он позволяет вам перечислить все страницы, которые имеют общую часть URL-адреса.

Например, предположим, что вы хотите найти все страницы, в URL-адресе которых есть слово «гайд»:

сайт:domain.com inurl:гайд

Вуаля!

сайт:domain.com -inurl:{часть-URL}

Вы заметили маленький знак минуса здесь «-inurl»? Это позволяет вам перечислить все URL-адреса, которые не содержат определенную строку в URL-адресе.

Допустим, вы хотите вывести список всех страниц, URL-адрес которых не содержат слова «блог».

Вот как вы это сделаете:

сайт:domain.com -inurl:блог

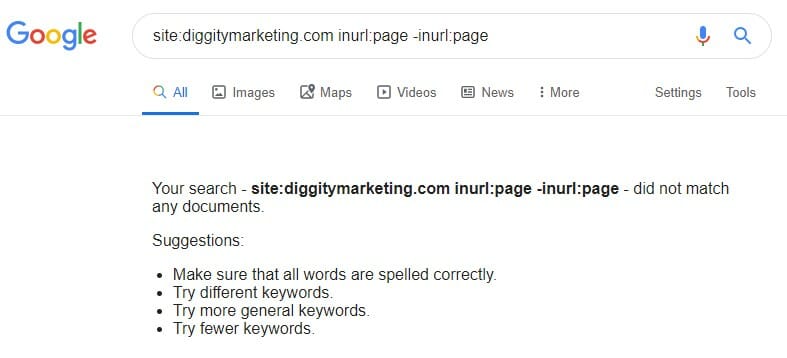

Комбинация: site:domain.com -inurl:{часть-URL} inurl:{другой-шаблон-URL}

Будьте готовы к действительно серьезному инструменту уже сейчас! Он представляет собой комбинацию операторов «inurl» и «-inurl» (не в URL-адресе) и позволяет вам перечислять страницы, которые имеют определенную строку в URL-адресе, но не имеют в нем другой части.

Например, если вы хотите перечислить все страницы вашего сайта, являющиеся гайдами, но не гайдами по продажам, вот как это сделать:

сайт:domain.com inurl:гайд -inurl:продажи

Обязательно не используйте пробелы между «:» и строкой!

Кроме того, будьте осторожны с запросами, в которых операторы взаимоисключают друг друга — Google просто ничего не найдёт!

Существует множество других комбинаций и операторов поиска, поэтому, если что-то из вышеперечисленного для вас в новинку, вам обязательно стоит прочитать о них больше здесь:

https://ahrefs.com/blog/google-advanced-search-operators

Приведите свою карту сайта в порядок

При написании этого гайда мы ещё раз убедились, что карта сайта XML должна быть правильно создана и доступна сканерам Google, чтобы они могли полностью понять структуру сайта и точно выдавать результаты на её основе.

Запустите сканирование с помощью Screaming Frog, чтобы убедиться, что в карту сайта не добавлены неиндексированные или отсутствующие URL-адреса.

Сначала переключитесь в «Режим списка (List Mode)» в Screaming Frog. Затем выберите «Загрузить (Upload)» → «Загрузить XML-карту сайта (Download XML)». Введите URL-адрес и позвольте ему просканировать.

Не должно быть никаких других страниц, кроме тех, которые возвращают код состояния 200.

Если они есть, просто удалите их из карты сайта!

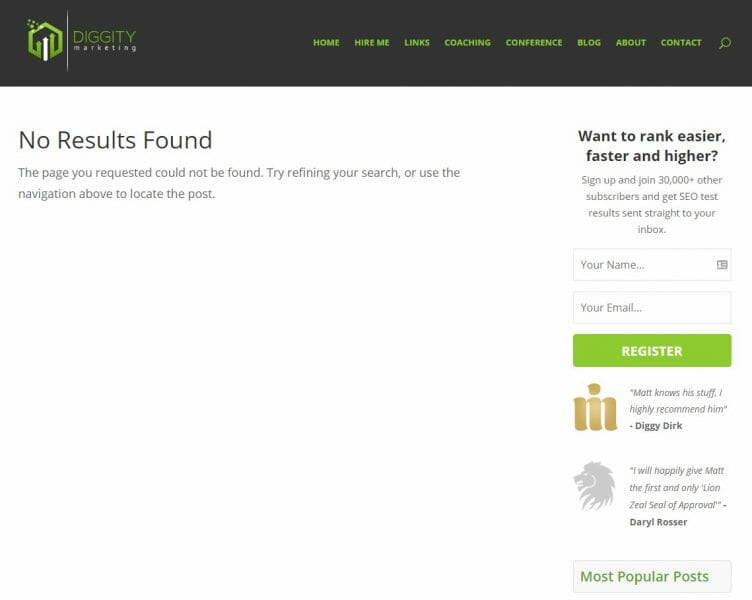

Ошибка 404

404 ошибка — это URL-адрес, который отображает страницу, сообщающую пользователю, что страница не существует, но возвращает запрос: 200 OK (успешно) вместо кода состояния HTTP 4xx.

Итак, вы столкнулись с проблемой: хорошие страницы, которые вы предпочитаете оставить в индексе, вылетают, потому что Google считает, что это ошибки 404.

Почему он так думает?

Скорее всего, между действительно хорошими страницами и страницами 404 есть сходство.

К сожалению, эти сходства не очевидны, и при алгоритмическом анализе их можно ошибочно принять за какой-то элемент сайта: футер, боковую панель, баннерную рекламу и т. д.

Итак, позвольте мне привести вам пример — вот как выглядит моя страница 404:

Он возвращает правильный код состояния 404, так что все в порядке:

Но есть одно но.

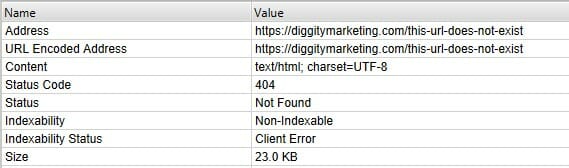

Допустим, у меня была страница с небольшим количеством контента – вот такая:

Как видите – у него другой контент, но все остальное то же самое: шапка, боковая панель, футер.

Если подойти к этому так, как это делает Google, то алгоритмически она может показаться очень похожей на приведенный выше пример страницы 404. Фактически, Google может классифицировать её так же . И это то, чего вы не хотите. Вы не хотите, чтобы Google решал за вас.

Мое правило: не позволяйте Google принимать за вас какие-либо решения!

Наша задача, как специалистов по поисковой оптимизации, — сделать так, чтобы Google было невероятно легко сканировать и индексировать ваш сайт. Поэтому не оставляйте ничего лишнего, над чем алгоритм может долго думать.

В этом случае у нас на всех страницах 404 был настроен 301 редирект обратно на главную страницу. Это обычная практика, но иногда опасная.

Почему это может быть опасно?

Потому что мы видели случаи, когда Google просто обрабатывал все 301 редиректы на домашнюю страницу как 404 ошибку. И когда он это сделает, он также может начать рассматривать вашу главную как страницу 404, потому что все эти 404 по умолчанию относятся к вашей домашней странице, верно?

И что это значит?

Вашей главной страницы НЕТ!

А когда нет главной страницы? Нет никаких позиций!

Но, если вам действительно не повезет, однажды 404 страница будет случайно выкинута из индекса Google и соответственно и главная страница тоже будет удалена из индекса и следовательно Гугл подумает, что сайт прекратил существовать и тогда он выкинет из индекса все имеющиеся страницы!!!

Звучит жестко!? Это так, но мы видели подобные случаи, поэтому лучше перестраховаться.

Поэтому мы используем 301 редирект только важные страницы, где это применимо. Под важными я подразумеваю страницы, имеющие внешние или внутренние ссылки и некоторую историю.

Мы оставляем ошибку 404 там, где это настоящая страница с контентом, только что удаленная с сайта, но все равно не имеющая никакой ценности.

Я знаю, о чем вы думаете: а как насчет исключений или ошибок при индексировании в консоли поиска Google?

Проще говоря, в данном случае – не надо делать НИЧЕГО! Потому что 404 ошибка это нормально. Google сообщит о них в GSC.

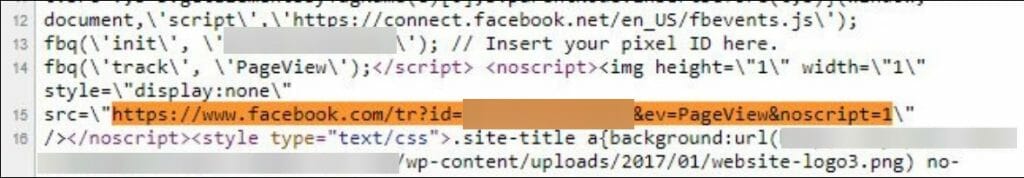

Исправление проблем с Facebook пикселем

Большинство компаний, занимающихся инфопродуктами, используют ретаргетинг Facebook, поэтому, если у вас есть инфопродукт (или он есть у вашего клиента), вам необходимо рассмотреть следующий вопрос.

Эту проблему было довольно сложно выявить, но наше сканирование показало, что поисковые пауки могут переходить по пикселям фейсбук:

Итак, как вы можете видеть (или не видеть, потому что большая часть изображения размыта) выше, поисковые сканеры обращались к таким страницам, как:

domain.com/ «https:/www.facebook.com/tr?id={идентификатор клиента в Facebook}&ev=PageView&noscript=1»

Мы толком не знали, как это возможно и чем это вызвано, но плагин, генерирующий Facebook Pixel, делал это неправильно…

Проблема заключалась в том, что обратные косые черты «выходили» из одинарных и двойных кавычек в коде Javascript, генерирующем пиксель:

Мы удалили плагин для Facebook и вставили код пикселя прямо в исходный код (файл header.php).

Наши специалисты по SEO постоянно жалуются, что в WordPress есть плагины буквально для всего. Даже для самых простых вещей, но они не всегда хорошо работают.

Так что, возможно, в следующий раз, когда вы подумаете об установке плагина, сделайте нам и себе одолжение – подумайте, действительно ли он нужен вам.

Не используйте плагины, если тоже самое можно сделать быстрее и проще с помощью простого ctrl+c и crtl+v

Структура заголовка

Это было довольно просто, но очень важно.

На сайте клиента не использовались никакие заголовки, кроме H2… Никаких. Совсем.

Я упоминал о важности семантических заголовков в другом кейсе , поэтому просто скажу, что здесь просто надо использовать все заголовки от H1 до H5.

Просто, но важно.

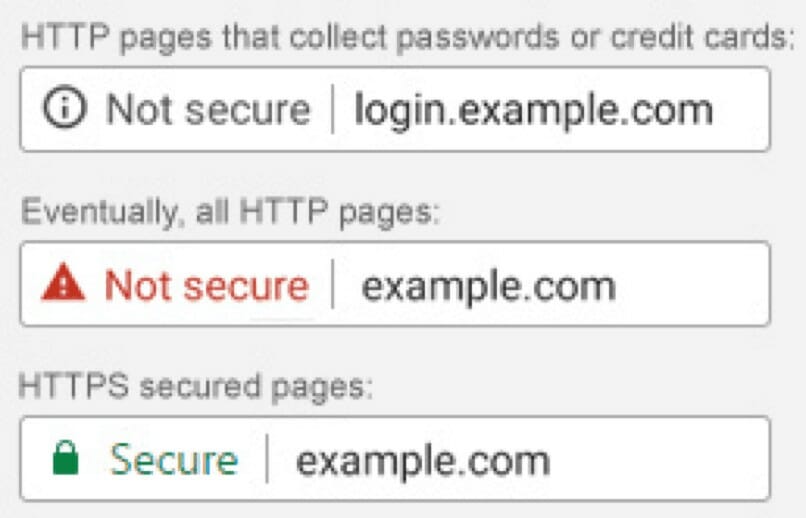

HTTP-страницы и YMYL

Незащищенные веб-страницы быстро выходят из моды.

Фонд Electronic Frontier Foundation активно продвигает распространение безопасного протокола HTTPS, используемого в сети.

Google также поддерживает эту идею, помечая контент, отличный от HTTPS, как «небезопасный» в Chrome.

У нашего клиента действительно была правильная реализация SSL, но возникла большая проблема.

Старые страницы HTTP не были перенаправлены на их версии HTTPS.

Находясь в нише YMYL (Ваши деньги или ваша жизнь), вы не должны оставлять никаких незавершенных дел.

Я имею в виду, что вы вообще не должны оставлять никаких незавершенных дел, но когда вы находитесь в нише YMYL , вы просто ОБЯЗАНЫ этого не делать.

Вы можете исправить это с помощью плагина Really Simple SSL , который сразу же включает редирект HTTP→HTTPS.

Но, как я уже говорил выше, вам не надо использовать плагины WP, когда это можно сделать руками.

Вот код .htaccess, который мы установили для правильного редиректа с HTTP на HTTPS и без www с www:

RewriteEngine OnRewriteCond %{HTTP_HOST} !^yourdomain.com [NC,OR]RewriteCond %{HTTP:X-Forwarded-Proto} =httpRewriteRule ^(.*)$ https://yourdomain.com/$1 [R=301,L]Однако будьте осторожны! Прежде чем нажать «Сохранить», убедитесь, что у вас есть доступ к FTP-серверу.

В некоторых случаях это может привести к поломке, и для повторного получения доступа к вашему сайту вам придется вручную изменить содержимое вашего файла .htaccess.

Вот, что вы должны увидеть при правильной настройке:

Таксономия контента и внутренние ссылки

Чтобы оптимизировать внутренние ссылки в многочисленных постах в блогах нашего клиента, мы рекомендовали реорганизовать категоризацию и таксономию контента сайта.

Для начала мы предложили создать больше категорий в WordPress и добавить их в главное меню.

Звучит просто, но на этом сайте была только одна большая категория (около 300 постов): и звучала она так «Блог».

Более того, чтобы сэкономить краулинговый бюджет, кто-то, к сожалению, не проиндексировал все страницы категорий и пагинации.

Мы создали 16 новых категорий в WordPress — все они соответствуют типу предлагаемого курса и области знаний, которую он преподает. Мы позаботились о том, чтобы в каждой категории было не более 20 постов.

Видите, что я имею в виду? Мы всеми руками за быстрые победы.

Мы также удалили теги noindex со страниц категорий.

Последний трюк заключался в том, чтобы добавить короткий тематически релевантный текст вверху каждой страницы категории (над постами), чтобы Google воспринимал их как нечто большее, чем просто список статей. Это означало больше любви от G!

Благодаря этому мы создали тематические кластеры по каждой категории.

Это помогает лучше организовать контент для удобства пользователя, а также облегчает поиск страниц роботами.

В результате этого процесса появилось больше внутренних ссылок на контент, что указывает на его важность в информационной архитектуре сайта.

Под каждым постом в блоге также был добавлен раздел «похожих публикаций», что усиливало те же преимущества, а также предоставляло дополнительные преимущества, помогая пользователям находить больше релевантного образовательного контента нашего клиента и улучшало поведенческие показатели и кликабельность.

Этап 2: Создание выигрышной контент-стратегии: методы SEO продвижения

Как только вы выполнили работы над сервером, сайтом, таксономии и индексацией, пришло время подумать о создании таргетированного контента, который одновременно отвечал на вопросы целевой аудитории и имел потенциал для ранжирования по наиболее важным поисковым запросам.

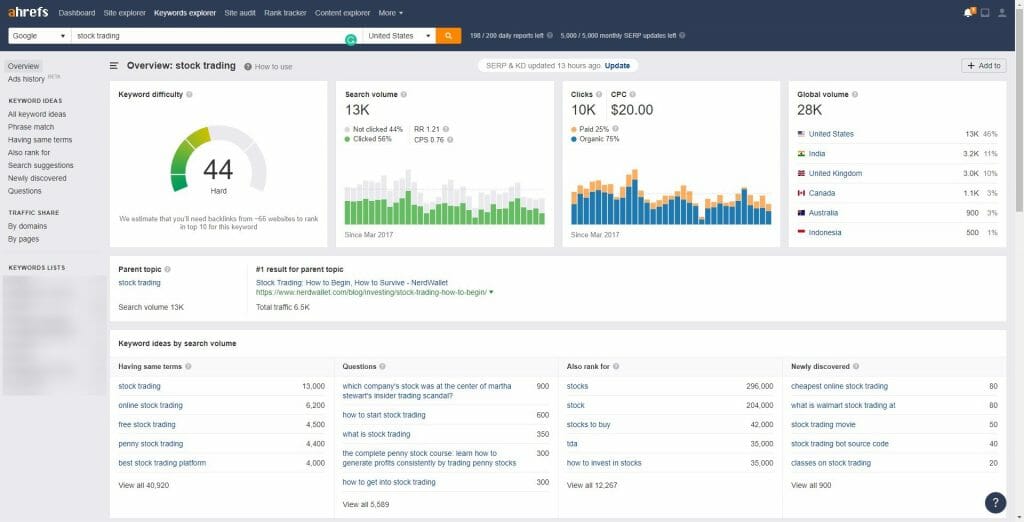

Используя Ahrefs, наша техническая команда изучила контент конкурентов по потенциальным ключевым словам, а также проанализировала конкуренцию по каждому ключевому слову.

Поверьте мне, как только у вас будет список ключевых слов или тем, которыми вы планируете заняться, инструмент Keyword Explorer от Ahrefs станет очень полезным:

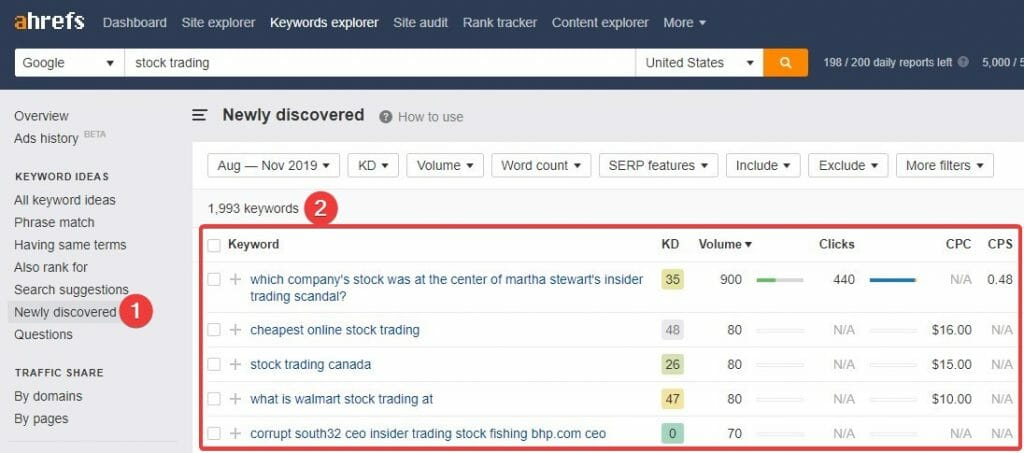

А чтобы похожие ключевые слова, вам просто нужно перейти из Обозревателя ключевых слов (Keyword Explorer) в раздел «Недавно обнаруженные (Newly Discovered)», и вы увидите все примеры новых ключевых слов:

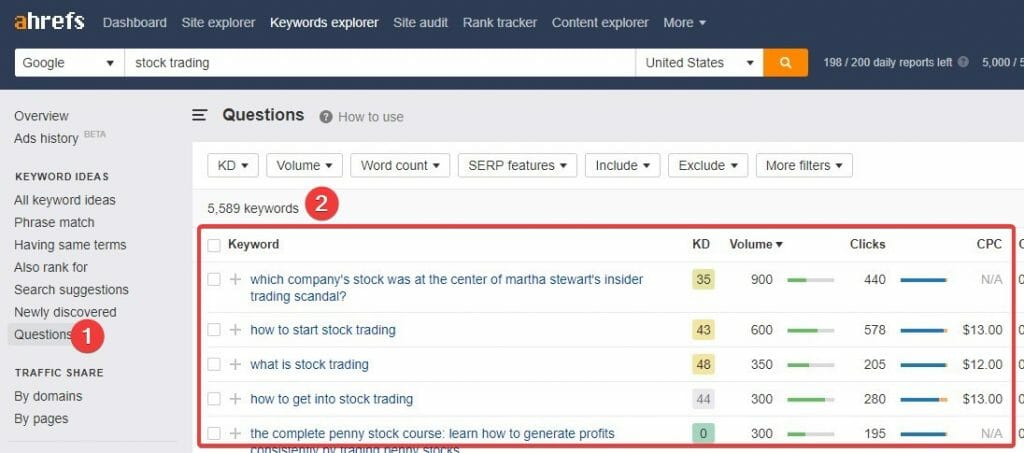

Еще один достойный вариант категория — Вопросы (Questions):

Отсюда вы можете просто выбрать ключевые слова, которые вам нравятся, принимая во внимание их сложность и объем поиска.

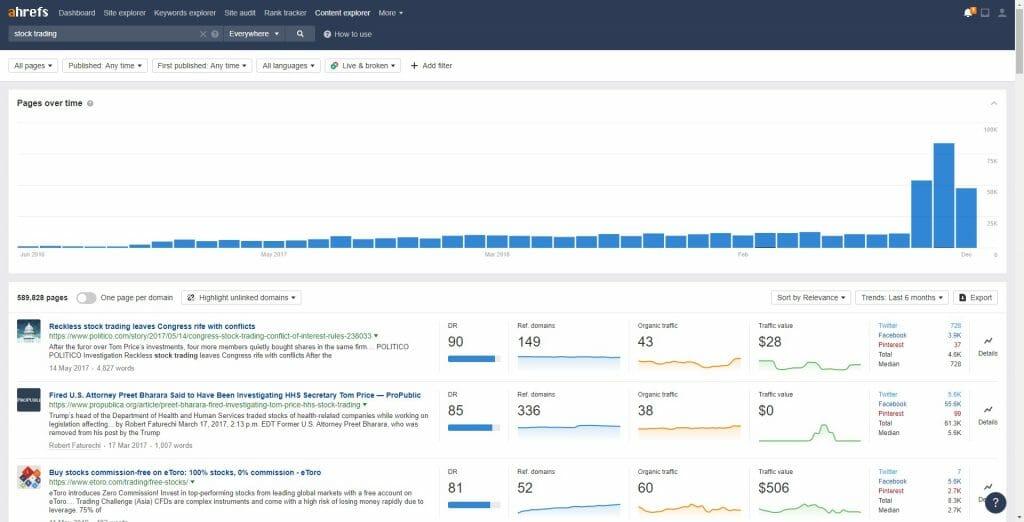

Но если вы действительно хотите улучшить свой контент-план, вам нужно воспользоваться Content Explorer на Ahrefs:

Для нашего клиента мы оценили среднемесячные объемы поиска и учли вероятные намерения пользователей по каждой вертикали ключевых слов.

А если говорить об интенте пользователей – поверьте мне, это уже весомый фактор, но в 2024 году он ещё более весомым.

Это процесс исследования контента, необходимый для разработки стратегии, направленный на создание контента для максимального удовлетворения запроса пользователя по ключевому запросу.

Оптимизация контента и каннибализация ключевых слов

Следующей задачей было взглянуть на существующие фрагменты контента двумя способами:

- Пропустите его через Surfer SEO – чтобы улучшить контент.

- Запустите аудит каннибализации ключевых слов.

Раньше я довольно много говорил о каннибализации ключевых слов.

На самом деле, я думаю, что это одна из самых распространенных проблем, связанных с контентом, в этом году.

Я вам говорю, это чума для индустрии!

Мы прогнозируем, что проблемы каннибализации ключевых слов станут менее серьезной проблемой, когда Google станет умнее в понимании естественного языка (подсказка: Neural Matching и BERT), но, вероятно, эта проблема останется горячей темой и большой проблемой на долгие годы.

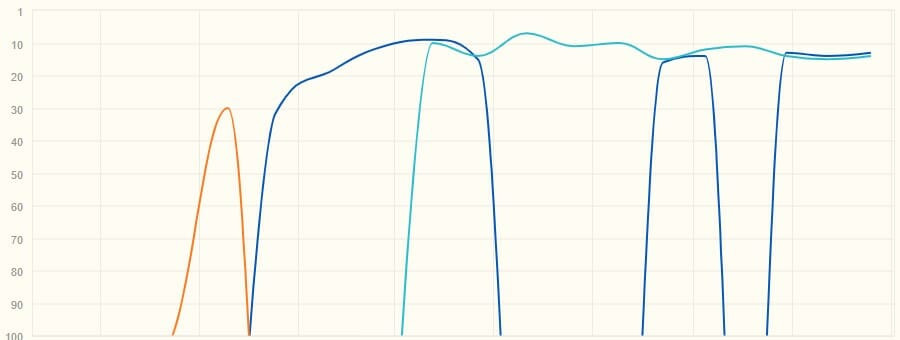

Итак, в данном случае мы столкнулись с довольно серьёзным случаем каннибализации ключевых слов. Из примерно 300 проиндексированных статей 50 имели двойное или тройное пересечение позицих по ключам. Это был сильный аргумент в сторону того, что эту проблему надо решать.

Это лишь одно из ключевых слов:

Поскольку мы не являемся экспертами в рыночной торговле и финансовых инструментах, нам пришлось обратиться к клиенту за советом. Мы объединили список всех каннибализирующих URL-адресов и ключевых слов и предоставили его на рассмотрение нашему клиенту.

Когда мы получили обратную связь о том, какие страницы можно объединить, удалить или обновить, работа началась: мы переместили и объединили контент.

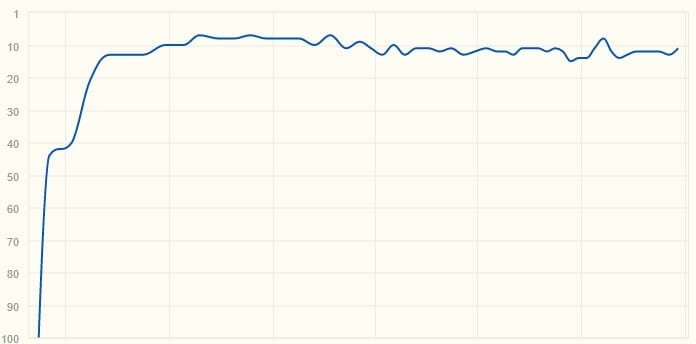

И вот, что у нас получилось:

Тем временем мы удалили ненужные страницы и оптимизировали (или деоптимизировали) те, которые не были предпочтительными, но должны были оставаться на сайте.

При этом мы смогли повысить ценность существующего контента и получить максимально возможный трафик от предыдущих инвестиций клиента в контент.

Если вы хотите узнать больше о том, как получить тонны трафик с помощью оптимизации контента, посмотрите это видео ниже.

Этап 3: Стратегия построения авторитетных ссылок

Неотъемлемой частью любой эффективной SEO-кампании является создание высококачественных обратных ссылок.

Проведите полный аудит своего профиля обратных ссылок, и вы, скорее всего, обнаружите как обратные ссылки более низкого качества, так и некоторые ссылки высочайшего качества.

Сразу же были деактивированы некоторые обратные ссылки самого низкого качества.

Кроме того, проведите аудит распределения анкорного текста.

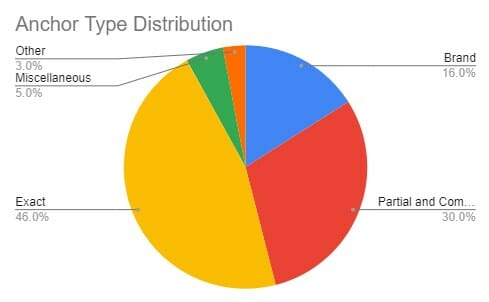

В нашем случае нас немного беспокоило распределение текста анкоров, имеющее слишком много точных и частичных совпадений (связанных с ключевыми словами, но не обязательно включающих ключевые слова напрямую).

Это выглядело так:

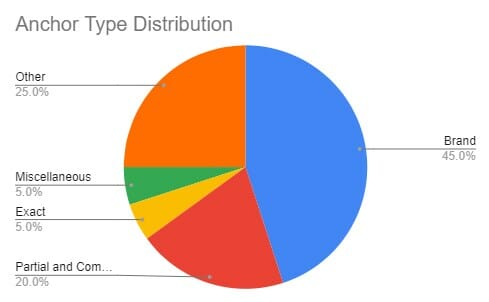

А должно выглядеть примерно так:

Имея это в виду, в течение первого месяца рекламной кампании мы разместили около 25 социальных ссылок (мы создали учётные записи в социальных сетях, сделали несколько страниц «Об авторе» в публикациях, в которых он участвовал, и опубликовали несколько статей на Medium) с брендовым анкором.

В следующие два месяца мы стали применять более безопасный подход — выкладывать статьи на сторонние ресурсы. Все это было сделано для того, чтобы сбалансировать ситуацию.

Наша команда по связям с общественностью начала процесс установления контактов с соответствующими сайтами, которые были рады разместить обратные ссылки на нашего клиента на своих доменах.

В первый месяц команда провела переговоры и создала 9 сильных (DR 50+) обратных ссылок на сайт и смогла договориться о 5-8 высокоавторитетных ссылках каждый месяц.

Вот статистика ссылок нашей информационно-пропагандистской работы:

Это быстро повысило авторитет домена, тем самым улучшив видимость в интернете, ну и конечно же сами позиции.

Какие результаты мы получили от нашего выигрышного метода SEO продвижения?

Завершив нашу кампанию с использованием методов, описанных в этом тематическом кейсы , мы смогли добиться ощутимого роста для нашего клиента.

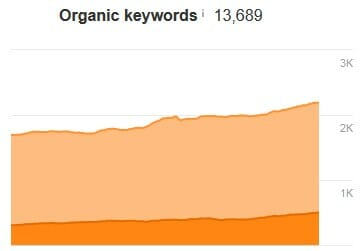

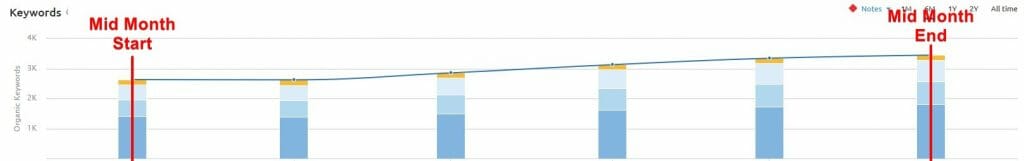

После 5 месяцев работы видимость ключевых слов в первой десятке увеличилось на 28% и поднявшись с 1713 позиций до 2188.

Стабильный рост также демонстрирует SEMRush:

Это значительно увеличило органический охват образовательного бизнеса всего за 5 месяцев и привело к увеличению количества сеансов на 23,46%, увеличению числа пользователей на 18,46% и увеличению доходов на 45,99% при сравнению первого и пятого месяцев кампании.

По сравнению с предыдущим годом, с нашей помощью сайт достиг увеличения органического трафика на 252,78% и увеличения достижения целей на 263,24%.

Результаты этой кампании говорят сами за себя.

После 5 месяцев работы наш клиент увидел хорошую отдачу от инвестиций (ROI), и наши проверенные стратегии будут продолжать приносить плоды в дальнейшем, поскольку бизнес не планирует сворачивать свою деятельность.

Заключение

Когда клиент доверяет вам, то он обменивает свои кровно заработанные деньги на то, чтобы вы работали над их бизнесом, их детищем.

В этом конкретном примере давили сроки (всего 5 месяцев), ведь надо было сделать хороший результат в одной из самых сложных ниш, которые только можно себе представить.

Но если сосредоточиться на быстрых победах и оптимизировать то, что уже было у клиента, такие результаты достижимы.

Давайте подведем итоги… и вы тоже не забудьте сосредоточиться на:

- Техническом SEO прежде всего. Без крепкой лодки вы никуда не поплывете. Не пропускайте ничего из раздела технического SEO.

- Оптимизация и стратегия контента. Это та область, на которую вы хотите сделать ставку в ближайшие годы.

- Качественные обратные ссылки – ориентированы на авторитет и хорошо выстроенный ссылочный профиль.

Пока вы делаете правильные вещи: исправляете недочёты, обеспечиваете ценность для клиентов и делаете сайт простым для понимания Google – вы всегда будете на коне.

А, если вам понадобится моя помощь вы всегда сможете найти мою контактную информацию по ссылке «Контакты».